最近、SNSやネット上で、非常にリアルなイラストや写真を目にする機会が増えました。「これ、AIが作ったのかな?それとも本物の写真?」と、思わず画像を拡大して見入ってしまうことも少なくないでしょう。

生成AIの進化は、私たちクリエイターにとって、アイデアを形にする時間を短縮し、新しい表現を生み出す強力なツールです。しかしその一方で、人間が作ったものと見分けがつかないレベルで世の中に溢れ始めているのも事実です。

「クライアントワークで使おうとしているこの素材は、本当に信頼できるだろうか?」

「自分が制作した作品が、意図しない形でフェイクニュースの一部として悪用されるリスクはないか?」

こうした真偽不明のコンテンツの存在は、クリエイターの活動に直接的なリスクをもたらします。制作に集中すべき貴重な時間を、素材の真偽確認といった作業に費やす必要も出てきています。

そんな中、GoogleのAI研究開発をリードするDeepMindが、実験的なツール「Backstory」の開発を進めているという情報が公開されました。

このBackstoryは、単に「AIか人間か」を判定するだけのツールではありません。画像の出自や使われ方の履歴といった「文脈」を分析し、その信頼性を判断する材料を提供するツールです。

本記事では、この「Backstory」の機能や背景にある技術、そしてAIコンテンツの信頼性をめぐる世界の最新動向を解説します。AI時代にクリエイターが安心して創作活動に取り組むための、具体的な判断材料を提示できれば幸いです。

この記事で分かること📖

🔍 身近な脅威:AIによる偽情報が、クリエイターにどんなリスクをもたらすのか

🛠️ Backstoryの正体:Googleの新ツールが持つ「文脈を読む力」とは何か

⚙️ 裏側の技術:見えない透かし「SynthID」と、業界標準「C2PA」の仕組みと違い

🏢 主要企業の戦略:GoogleやAdobe、Metaは、この問題にどう取り組んでいるのか

🤔 クリエイターの心構え:技術の限界を知り、私たちが今から備えるべきこと

なぜ今「画像の出自」が重要なのか? – クリエイターを襲う見えない脅威

「フェイクニュース」という言葉は聞き慣れているかもしれませんが、ジェネレーティブAIの登場で、その脅威は質・量ともに変化し、もはや他人事ではなくなっています。かつては専門家が多大な時間とコストをかけていた「ディープフェイク」のようなコンテンツが、今や誰でも手軽に、そして大量に生み出せる時代になりました。

これが、私たちクリエイターにとって何を意味するのか。具体的なリスクを少し見てみましょう。

社会を揺るがすフェイクの威力

AIによって生成された偽の情報は、もはや単なるイタズラでは済まされません。

- 選挙への介入: 特定の候補者に投票しないよう呼びかける、本物そっくりの偽音声が拡散される。

- 国際問題への発展: 一国のリーダーが降伏を呼びかける、精巧なディープフェイク動画が作られる。

- 個人の尊厳を傷つける: 社会活動家の信用を失墜させる目的で、加工された画像が出回る。

これらはすべて、実際に世界で起きた事例です。自分が何気なく「すごいな」と思ってシェアしたコンテンツが、実は誰かを傷つけたり、社会を混乱させたりする意図を持って作られたものだったら…と考えると、その影響の大きさに気づかされます。

クリエイターを襲う経済的リスク

その影響は経済にも及んでいます。例えば、2013年にAP通信(Associated Press)のX(旧Twitter)アカウントがハッキングされ、「ホワイトハウスで爆発があった」という偽情報が投稿された結果、わずか数分で株式市場から1360億ドル(当時のレートで約13兆円)もの価値が失われました。(World Economic Forumより)

これは極端な例に聞こえるかもしれませんが、リスクはもっと身近なところに潜んでいます。

- 損害賠償リスク: クライアントに納品した制作物の中に、知らずに権利関係の不明なAI画像や、悪意を持って作られたフェイク画像を使用していた場合、クライアントのブランドを傷つけ、損害賠償問題に発展する可能性があります。

- 信用の失墜: フリーランスのデザイナーやイラストレーターにとって、信用は最も大切な資産です。一度でも問題のある素材を使ったとなれば、「あのクリエイターは大丈夫か?」と、仕事の依頼が来なくなるかもしれません。

- 企業のリスク: 企業にとっても、自社製品の広告に不適切な画像を使ってしまえば、消費者からの信頼を失い、不買運動につながる恐れさえあります。

私たちクリエイターは、常に「信頼性」を問われる立場にあります。意図せずして偽情報の発信源になったり、制作物の素材が原因でトラブルに巻き込まれたりする可能性は、決してゼロではないのです。

「信頼」が溶けていく社会

そして最も根深く、深刻な問題が「社会全体の信頼の侵食」です。

何が本物で、何が偽物なのか。その境界線が曖昧になることで、私たちはメディアや専門機関といった、社会の土台となるものへの信頼を失っていきます。この現象はインフォデミック(Infodemic:真偽不明の情報が爆発的に拡散し、社会が混乱する状態)とも呼ばれ、世界経済フォーラムが「世界のトップリスク」の一つに挙げるほど、重大な課題として認識されています。

クリエイターの仕事は、ビジュアルを通して何かを「伝える」ことです。その「伝える」という行為そのものの信頼性が揺らいでしまっては、活動の基盤が崩れてしまいます。だからこそ、コンテンツの出自や来歴(どこで生まれ、どういう経緯を辿ってきたか)を明らかにし、その信頼性を担保する技術が、今、強く求められているのです。

注目ポイント📌

🚨 偽情報はクリエイターのリスク: 意図しない素材の使用が、損害賠償や信用の失墜といった深刻なビジネスリスクに直結します。

💼 信頼が資産: 私たちの仕事は信頼の上に成り立っています。コンテンツの出自を意識することが、自分自身のブランドを守ることに繋がります。

🤝 プロヴェナンスの重要性: 出自や来歴を明らかにすることが、クリエイティブ業界全体の信頼性を維持し、安心して創作できる環境の土台となります。

Googleの新兵器「Backstory」とは? – ただのAIチェッカーじゃない”文脈”を読む力

こうした深刻な問題を背景に、GoogleのAI研究を牽引する組織「Google DeepMind」が開発を進めているのが、実験的なAIツール「Backstory」です。

Google DeepMindとは?

少しだけ、Google DeepMindについて触れておきましょう。彼らはイギリスに本拠を置くGoogle傘下のAI企業で、まさに世界のAI研究の最先端を走る組織です。2016年に囲碁の世界チャンピオンを破ったAI「AlphaGo(アルファ碁)」を開発したことで、その名を知った方も多いかもしれません。彼らはゲームAIだけでなく、タンパク質の立体構造予測「AlphaFold」で生命科学に革命をもたらすなど、AI技術を応用して人類の大きな課題を解決することを目指している、トップクラスの研究集団です。

そんな彼らが開発するBackstoryの何が画期的なのか。それは、単純な「AI判定」で終わらない、その奥深い分析力にあります。

ユーザーが画像とプロンプトを入力すると、Backstoryは画像を調査し、分かりやすいレポートを生成します。そのレポートは、主に以下の問いに答えるように設計されています。

- その画像はAIによって生成されたものか?

- デジタル的に手が加えられているか?

- いつ、どこで、過去にネット上で使われたことがあるか?

- その画像のストーリーや文脈は、時間と共にどう変わっていったか?

「全体を捉える」アプローチの重要性

Googleが特に強調しているのが、最後の「文脈」を読み解く力です。これは、単にAI製か否かという二元論ではなく、その画像が持つ背景まで含めて全体を捉えて総合的に判断する、というアプローチです。

これまでのAI検出ツールは、「AI製か、人間製か」という判定に主眼を置いていました。しかし、この方法には限界がありました。例えば、英語が母国語でない人の誠実な文章を「AIが書いた可能性が高い」と誤判定してしまう、といった精度の問題が指摘されてきたのです。

さらに重要なのは、偽情報の核心は、必ずしも「AIが作ったかどうか」だけにあるわけではない、という点です。

例:ある国で起きた本物の抗議活動の写真を、全く別の国の、全く関係ない事件の様子だとしてSNSに投稿する。

この場合、写真そのものは「本物」で、一切加工されていません。しかし、本来の文脈から切り離されて使われることで、それは完全に誤解を招く「偽情報」になってしまうのです。

デザイナーの視点から見ても、これは非常に重要なポイントです。例えば、フリー素材サイトで見つけた笑顔の人物写真。素材としては何の問題もなくても、もしその写真が詐欺事件の犯人像としてSNSで拡散されてしまった過去があったらどうでしょう?そんな背景を知らずに自社の広告に使ってしまえば、ブランドイメージを大きく損ないかねません。

Backstoryが目指しているのは、まさにこの「文脈の歪み」や「見えないリスク」を明らかにすること。画像の技術的な構成だけでなく、その画像がネット上をどのように旅して、どのような物語をまとってきたのかを追跡する。これにより、Backstoryは単なる「フェイク検出器」ではなく、画像の来歴と文脈を解き明かす「分析ツール」としての価値を持つことになります。

まだ「実験的」なツール

ただし、現時点でBackstoryは一般公開されていません。「実験的なツール」として位置づけられており、一部のジャーナリストや専門家といった「信頼できるテスター」と協力しながら、慎重に開発が進められています。すぐに誰もが使えるわけではありませんが、社会に与える影響の大きい技術だからこそ、その精度と信頼性を高めるために、こうした段階的なアプローチを取っているのです。

注目ポイント📌

🕵️ デジタル履歴書を調査: Backstoryは、AIか否かだけでなく、いつ、どこで、どのように使われてきたかという「文脈」まで調査します。

CONTEXT 文脈が命: 本物の画像でも、文脈が違えば偽情報に。この「見えないリスク」を可視化できる点が、クリエイターにとって大きな価値を持ちます。

🧪 信頼性重視の開発: 現在は専門家と協力してテスト中。社会実装に向けて、信頼性を第一に考えた慎重な開発が進められています。

Backstoryを支える2つの心臓 – 「Gemini」と見えない透かし「SynthID」

Backstoryがこれほど高度な分析を可能にする背景には、Googleが誇る2つの強力な技術が存在します。それが、AIモデル「Gemini」と、電子透かし技術「SynthID」です。

オペレーションの頭脳:Geminiモデル

Backstoryの分析能力の核となっているのが、Googleの最新フラッグシップAIモデル「Gemini(ジェミニ)」です。

Geminiの最大の特徴は、その卓越した「マルチモーダル能力」です。これは、テキスト、画像、音声、コードといった複数の異なる種類の情報を、人間のように同時に理解し、関連付けて処理できる能力のこと。

Backstoryは、このGeminiの力を利用して、

- ユーザーが入力した質問(テキスト)

- 分析対象の画像データ

- Googleが持つウェブ上の膨大な情報(インデックス)

これらすべてを統合的に分析します。だからこそ、単に画像内のピクセル情報を調べるだけでなく、「その画像が過去にどのウェブサイトで、どのような文章と共に掲載されていたか」といった、複雑な文脈調査が可能になるのです。まさに、Backstoryのパワフルな頭脳と言えるでしょう。

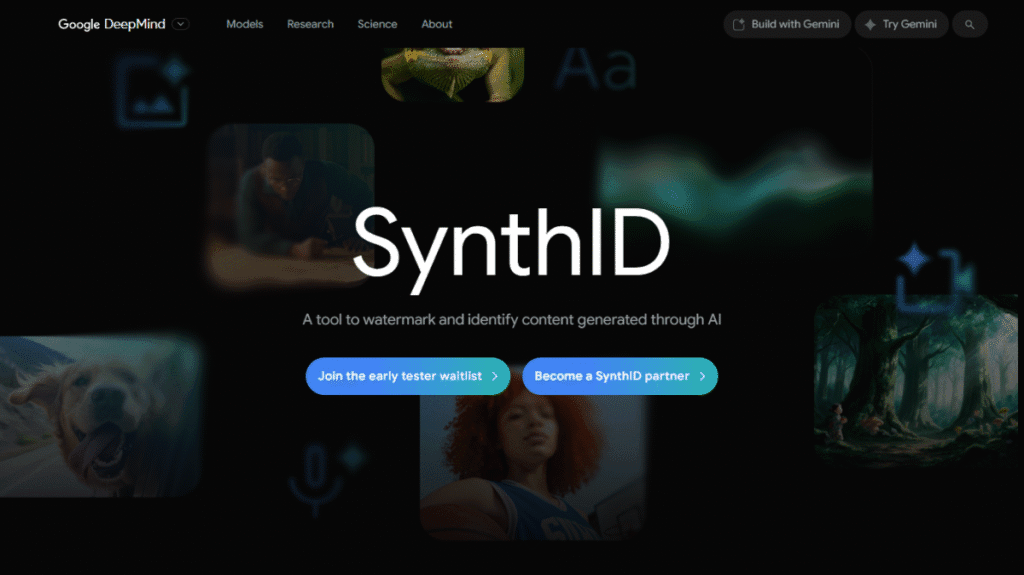

隠された署名:SynthIDの導入

そしてもう一つの心臓部が、「SynthID(シンセ・アイディー)」です。これは、AIコンテンツに「見えない電子透かし(デジタルウォーターマーク)」を埋め込む、Google DeepMindが開発した画期的な技術です。

ここで、BackstoryとSynthIDの関係を整理しておきましょう。

- SynthID(シンセ・アイディー): AIがコンテンツ(画像、音声、テキストなど)を生成する瞬間に、人間には知覚できない「これはAI製ですよ」という電子透かしを埋め込む技術。

- Backstory(バックストーリー): ネット上にあるあらゆる画像(SynthIDの透かしがあるものも、ないものも)を調査するためのアプリケーション。

例えるなら、SynthIDは製品に製造元を示す印を入れる技術、Backstoryはその印を読み取ったり、印がない製品の出自を調べたりする高性能な鑑定ツール、というイメージです。

この「生成時に印をつける(SynthID)」と「流通後に調査する(Backstory)」という二段構えこそが、Googleの戦略の巧みなところ。この2つのアプローチによって、より幅広く信頼性の問題に対応しようとしているのです。

SynthIDの仕組みと戦略

SynthIDは、コンテンツの種類に応じて、非常に巧妙な方法で透かしを埋め込みます。

- 画像: 人間の目には全く見えないレベルで、画像のピクセル(画像を構成する最小単位の点)の色や明るさをわずかに調整します。この透かしは、画像を圧縮したり、トリミングしたり、フィルターをかけたりといった、一般的な加工をしても消えにくいように設計されています。

- 音声: 人間の耳には聞こえにくい周波数帯に情報を隠します。驚くべきことに、一度スピーカーで再生し、それをマイクで録音するような、アナログな経路を経ても情報が失われにくいように作られています。

- テキスト: 最も技術的に難しい分野ですが、AIが文章を生成する際の単語の選び方を、ごくわずかに調整します。これにより、後から統計的に分析すると「これはAIが書いた文章だ」と判別できるパターンを埋め込むのです。

このように、SynthIDはコンテンツそのものに溶け込む形で情報を埋め込むため、より偽造されにくい証明となり得ます。

そして、Googleの戦略で注目すべきは、このSynthIDを完全に独占するのではなく、一部技術(特にテキスト向け)をオープンソース化している点です。開発者が集まるプラットフォーム「Hugging Face」などで利用可能にすることで、広くフィードバックを集め、技術を改善すると同時に、業界内でのSynthIDの利用を促し、事実上の標準(デファクトスタンダード)としての地位を確立しようという巧みな戦略が見え隠れします。

ワンポイントアドバイス📌

🧠 頭脳はGemini: 複数の情報を同時に理解するAIが、Backstoryの高度な文脈分析を可能にしています。

🏷️ 刻印はSynthID: AIコンテンツの生成時に、人間には見えない「AI製の証」をコンテンツ自体に埋め込む技術です。

🏆 標準化も狙う戦略: SynthIDはGoogleの独自技術ですが、一部をオープンソース化することで、業界標準の座を狙うという側面も持っています。

AIを見破る技術の最前線 – 「作る時に入れる」か「後から調べる」か

AIコンテンツの真贋を見分ける技術は、大きく分けて2つのアプローチに分類できます。それは、コンテンツが「作られる時」に対策するのか、「作られた後」に分析するのか、という考え方の違いです。この2つの流れを知ることで、BackstoryやSynthIDが、技術全体の中でどのような位置づけにあるのかが、よりクリアに見えてきます。

アプローチ1:プロアクティブ検出(作る時に対策)

これは「先手必勝」のアプローチ。コンテンツが生成される、まさにその瞬間に何らかの印(マーキング)をつける方法です。

- 代表例:

- 電子透かし(SynthID、MetaのStable Signatureなど): コンテンツ自体に、人間には知覚できない信号を埋め込む。

- メタデータ標準(C2PAなど): 「誰が、いつ、何を使って作ったか」という情報を、暗号化してファイルに添付する。

- 強み: 信頼性が高く、検証可能な証明を提供できる可能性がある点。

- 弱み: AIモデルを開発している側の協力が不可欠で、非協力的な開発者が作ったAIコンテンツには無力な点。

アプローチ2:リアクティブ検出(作られた後から分析)

これは「後出し解析」のアプローチ。完成したコンテンツを分析し、AIが作りがちな「クセ」や統計的な痕跡を探し出す方法です。

- 代表例:

- GPTZero, Copyleaks, Turnitinなど、多くのサードパーティ製AI検出ツール。

- 強み: どんなソースから来たコンテンツでも、とりあえず分析にかけることができる手軽さ。

- 弱み: 信頼性が低く、誤判定(人間が書いたものをAI製と判定するなど)のリスクがつきまとう点。

リアクティブ検出ツールの現実と課題

おそらくクリエイターの皆さんの中にも、文章がAIによって書かれたものかどうかをチェックするツールを使ったことがある方がいるかもしれません。これらの多くが「リアクティブ検出」に分類されます。

これらのツールは、AIが生成する文章にありがちな「表現の滑らかさ(予測しやすさ)」や「文章構造の揺らぎの少なさ」といった統計的な特徴を分析します。ウェブサイトでは「99%の精度!」といった宣伝文句が並びますが、その実態は、決して鵜呑みにはできません。

- バイアスの問題: 英語を母国語としない人が書いた誠実な文章を、「AIが生成した可能性が高い」と誤判定してしまうケースが報告されています。

- 高い誤検知率: ある大学では、教授がAI検出ツールを使い、クラス全員の提出物を不正だと誤って告発してしまう事件も起きました。

- 回避が容易: 文章の表現を少し変えたり、人間が手直ししたりするだけで、簡単に見破れなくなってしまいます。

リアクティブ検出は手軽な一方で、こうした深刻な欠点を抱えています。だからこそ、GoogleのSynthIDや、後述するC2PAのような「プロアクティブ」なアプローチが、より本質的な解決策として期待されているのです。

注目ポイント📌

🆚 2つのアプローチ: 「作る時に入れる」プロアクティブ方式と、「出来たものを調べる」リアクティブ方式があります。

⚠️ AIチェッカーの過信は禁物: 手軽なリアクティブ検出ツールには、誤判定やバイアスのリスクが伴うことを理解しておく必要があります。

🛠️ 信頼性の違い: プロアクティブ方式は開発者の協力が必須ですが、より信頼性の高い証明を提供できる可能性があります。

「絶対」はない? – 検出技術をめぐる”いたちごっこ”の現実

SynthIDのような先進的な電子透かし技術は、非常に頼もしく思えます。しかし、残念ながら「これで全て解決!」というわけにはいかないのが、この世界の難しいところ。防御システムがあれば、その穴を突こうとする攻撃者が必ず現れます。

攻撃者の多様な手口

攻撃者が狙うのは、単に検出システムを突破することだけではありません。その手口は主に2つに分けられます。

- 回避(Evasion): AIが生成したコンテンツを、あたかも人間が作ったかのように見せかけて、検出システムをすり抜ける行為。

- 偽装(Impersonation): 逆に、人間が誠実に作成したコンテンツを、AIが生成したかのように見せかけて、その信頼性を貶める行為。

このように、攻撃は単純な「すり抜け」だけでなく、混乱を助長するような、より悪質な形でも行われる可能性があるのです。

電子透かしのアキレス腱:除去攻撃

どんなに巧妙に隠された透かしも、「それを見つけて消してしまえ」と考える人々がいます。

その代表例が、ウォータールー大学の研究者が開発した「UnMarker」というツールです。このツールは、電子透かし技術が「画像の品質を大きく損なうわけにはいかない」という根本的な制約を逆手に取ります。画像内のピクセルの周波数などを分析し、透かしとして埋め込まれた微弱な信号を発見し、それを効果的に除去してしまうのです。

研究者たちは、誰でも利用可能で効果的な透かし除去ツールが存在するという事実は、「防御的な電子透かしがディープフェイクに対する決定的な防御策ではない」ことを示している、とまで述べています。

あらゆる検出システムに共通するジレンマ

この分野は、本質的に、防御技術と攻撃技術が追いかけっこを続ける、終わりなき「いたちごっこ」の様相を呈しています。

さらに、検出ツールには厄介なジレンマがつきまといます。ツールを一般に公開すれば、多くの人が恩恵を受けられますが、同時に攻撃者が回避策を編み出す手助けをしてしまいます。逆にツールを秘密にしておけば、攻撃者に悪用されるリスクは減りますが、一般のユーザーにとっては無用の長物となってしまいます。

そして忘れてはならないのが、国家が背後にいるような大規模な偽情報キャンペーンや、悪意のある攻撃者は、そもそも最初からSynthIDのような電子透かしを使いません。そうなると、結局は信頼性の低いリアクティブな手法に頼らざるを得なくなる、という根本的な問題が残ります。

これらの脆弱性は、システムの些細な欠陥ではなく、根源的な限界を示しています。つまり、コンテンツの真贋を、純粋に技術だけで100%解決するのは、おそらく不可能なのです。究極的な目標は、完璧な検出ではなく、「偽装するためのハードルを、可能な限り高くする」ことにある、と言えるでしょう。

注意事項📌

⚔️ 終わりなき攻防: 検出技術とそれを回避・除去する技術は、常に「いたちごっこ」の状態にあります。

🎭 攻撃は多様: 単純な検出逃れだけでなく、人間製をAI製に見せかける「偽装」攻撃も存在します。

🤔 技術は万能ではない: 純粋な技術だけで偽情報問題を100%解決することは困難です。ツールの限界を理解し、過信しないことが重要です。

もう一つの可能性「C2PA」 – オープンな”履歴書”で信頼を築く

GoogleのSynthIDが、自社のエコシステムを中心に信頼性を担保しようとするアプローチである一方、業界全体でオープンな基準を作ろうという、もう一つの大きな潮流があります。それが「C2PA(Coalition for Content Provenance and Authenticity)」です。クリエイターにとってお馴染みの企業が多数参加しており、今後のデジタルコンテンツのあり方を左右する可能性を秘めています。

C2PAとは?業界横断の連合チーム

C2PAは、日本語に訳すと「コンテンツの来歴と真正性のための連合」。その名の通り、デジタルメディアの信頼性を高めるために結成された、業界横断のプロジェクトです。

この標準の策定と普及を推進しているのが「コンテンツ真正性イニシアチブ(CAI)」で、Adobe、ニューヨーク・タイムズ、Twitter(現X)などが設立しました。そして、C2PAの創設メンバーには、

- Adobe: PhotoshopやIllustratorなど、クリエイター向けソフトウェアの最大手。

- Microsoft: WindowsやOfficeで知られ、近年はAI開発にも注力するテクノロジーの最大手。

- Intel: コンピュータの頭脳であるCPUのトップメーカー。

- BBC(英国放送協会): 世界的に信頼される公共放送機関。

など、ソフトウェア、テクノロジー、メディアの各分野を代表する企業が名を連ねています。まさに業界を挙げての取り組みであり、その本気度がうかがえます。

C2PAの仕組み:コンテンツの「栄養成分表示」

C2PAの具体的な実装は、「コンテンツクレデンシャル」と呼ばれています。これを一言で表すなら、デジタルコンテンツの「栄養成分表示」や「改ざん不可能な履歴書」のようなものです。

その仕組みは以下の通りです。

- C2PAに対応したカメラアプリや画像編集ソフト(Adobe Photoshopなど)でコンテンツを作成・編集すると、その情報が記録されます。

- 「誰が(どのデバイスやアカウントが)」「いつ」「どのツールを使って」作成・編集したか、といった情報がメタデータとしてファイルに添付されます。

- このメタデータは暗号技術で署名されており、後から改ざんされていないかを誰でも検証できます。

ユーザーは、コンテンツに付与された「コンテンツクレデンシャル」のアイコンをクリックするだけで、その画像や動画がAIで生成されたものか、どの部分がどのように編集されたか、といった来歴を簡単に確認できるのです。

なぜC2PAがデザイナーに選ばれるのか?

デザイナーの視点から見ると、このC2PAには非常に大きな価値があります。

私たちが日常的に使うPhotoshopにこの機能が標準搭載されれば、レイヤーを重ねたり、色調補正をしたりするたびに、その編集履歴が自動で記録されていくイメージです。

これにより、制作プロセスの透明性が劇的に向上し、「この部分はAIで生成し、こちらのレタッチは手作業で行いました」といった情報を、客観的なデータとしてクライアントに提示できます。これは、私たちの仕事に対する説明責任を果たし、より高い信頼を得ることに繋がります。

また、チームでの共同作業においても、誰がどこを編集したかが明確になるため、スムーズな連携や責任の所在の明確化に役立ち、無用なトラブルを防ぐことができます。

C2PAとブロックチェーン技術

C2PAの信頼性をさらに高める技術として、ブロックチェーンとの連携も進められています。

ブロックチェーンは「分散型台帳」とも呼ばれ、記録された情報を後から改ざんすることが極めて困難な技術です。この技術を使ってC2PAのクレデンシャル(履歴情報)を記録すれば、サーバーダウンなどで情報が消える心配がなく、半永久的に、そして誰にも消されることなく、その来歴を保証できるようになります。Numbers Protocolのようなプロジェクトが、この連携の具体的な実装例として挙げられます。

SynthIDとの比較:思想の違い

ここで、GoogleのSynthIDとC2PAの違いを比較してみると、その思想の違いがはっきりと見えてきます。

| Google SynthID | C2PA (コンテンツクレデンシャル) | |

|---|---|---|

| アプローチ | 埋め込み式 コンテンツのデータ自体に、見えない信号を埋め込む。 | 添付式 コンテンツとは別のメタデータとして、暗号化された履歴書をファイルに添付する。 |

| 標準 | プロプライエタリ(Google独自技術) ※一部はオープンソース化で標準化を狙う | オープンスタンダード 業界連合によって開発された、誰でも使える公開された標準規格。 |

| 主な目的 | 「これは特定のAI(主にGoogle製)によって作られたか?」を証明する。 | 「このコンテンツのライフサイクル全体の透明な履歴はどうか?」を証明する。 |

注目ポイント📌

🏢 業界の巨人たちが集結: AdobeやMicrosoft、大手メディアも参加するオープンな標準規格プロジェクトがC2PAです。

📄 コンテンツの”履歴書”: 制作プロセスを透明化し、クライアントへの説明責任を果たしやすくなるため、デザイナーにとって価値が高いです。

🔗 ブロックチェーンで信頼性向上: C2PAはブロックチェーンと連携することで、さらに改ざん困難な証明となる可能性を秘めています。

まとめ

AIによる偽情報のリスクが高まる一方で、その出自を明らかにするBackstoryやC2PAのような技術もまた、急速に進化しています。

しかし、どんな先進的な技術も万能ではなく、攻撃と防御の「いたちごっこ」が続いています。完璧な解決策が存在しないからこそ、私たちクリエイターは、ツールを盲信するのではなく、その特性と限界を理解した上で賢く利用する視点が不可欠です。

具体的には、SynthIDやC2PAといった技術の仕組みを学び、関連するルールの動向を追い、そして最終的には自分自身のリテラシー、つまり情報の本質を見極める力を養うこと。この3つのバランス感覚が、これまで以上に重要になります。

これらの技術動向を冷静に把握し、主体的に向き合っていくこと。それこそが、不確実な情報に振り回される時間を減らし、私たちが本来集中すべき創造的な活動の質と時間を確保するための、最も確実な方法と言えるでしょう。

免責事項

この記事は、公開されている情報を基に、AIとクリエイティブに関する筆者の見解をまとめたものです。特定の技術やサービスの完全性、正確性を保証するものではありません。Google DeepMindの「Backstory」および「SynthID」、ならびに「C2PA」に関する最新かつ正確な情報については、必ず各組織の公式サイトをご確認ください。本記事の内容を参照したことによって生じたいかなる損害についても、筆者は一切の責任を負いません。

📚 参考ソース

- Exploring the context of online images with Backstory – Google DeepMind

- About – Google DeepMind

- Behind the design: Adobe Content Authenticity app – Adobe Design

- Effects of AI-Generated Misinformation and Disinformation on the Economy – ResearchGate

- How AI-generated disinformation might impact this year’s elections and how journalists should report on it | Reuters Institute for the Study of Journalism

- Deepfakes and Democracy (Theory): How Synthetic Audio-Visual Media for Disinformation and Hate Speech Threaten Core Democratic Functions – PubMed Central

コメント